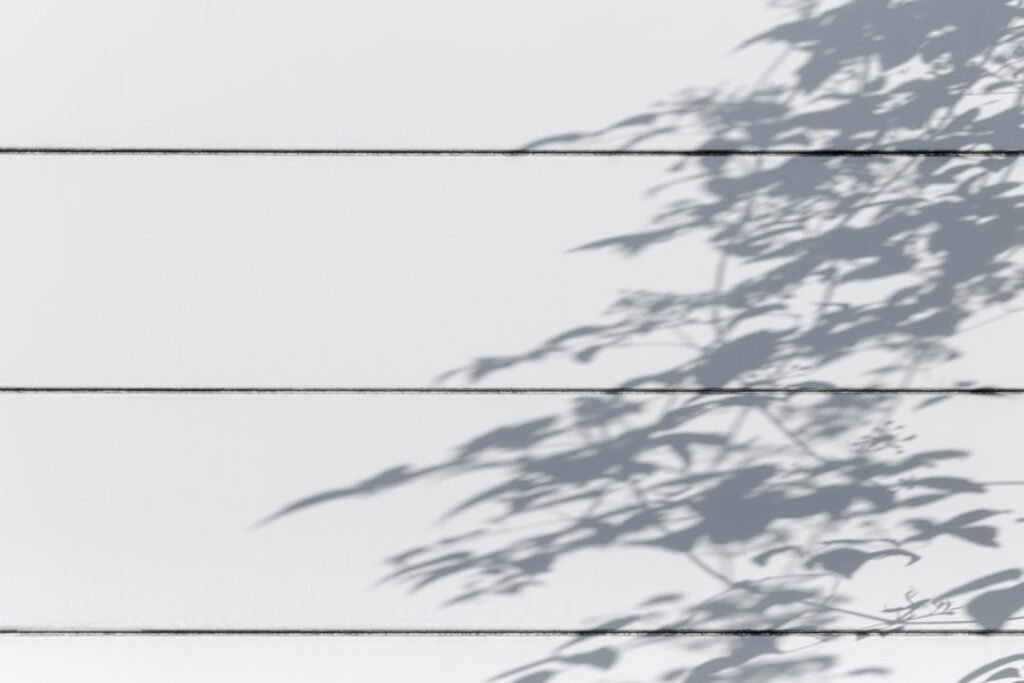

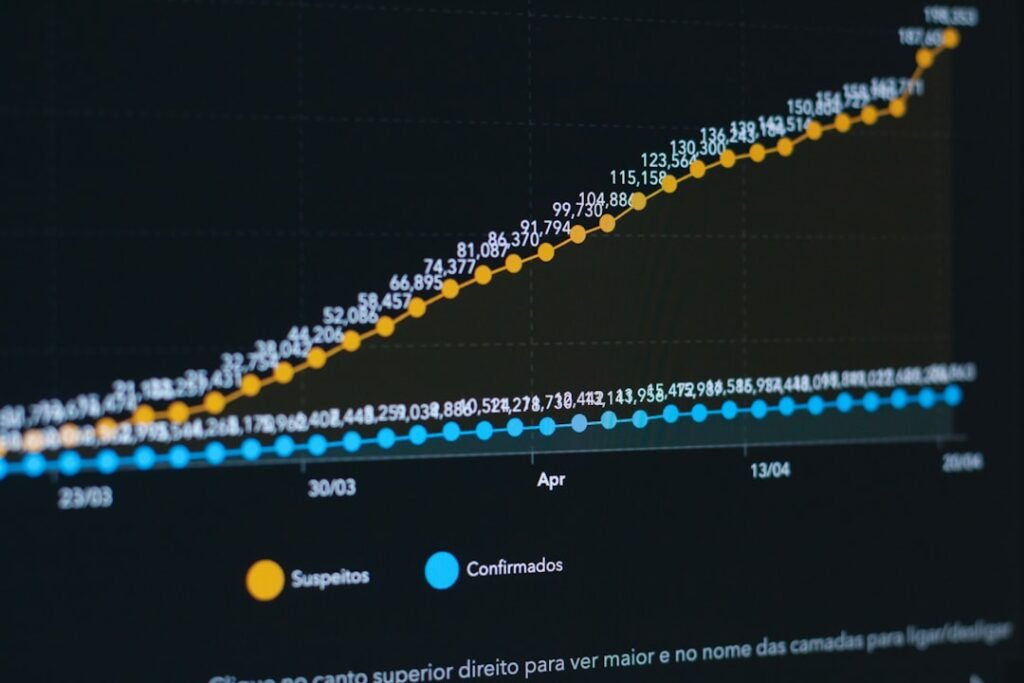

L’automatisation des processus RH devient un impératif stratégique pour les entreprises B2B. Cependant, elle soulève des défis majeurs en matière de conformité sociale et éthique. En effet, 72% des DRH estiment que l’IA transforme radicalement leur fonction, mais seulement 38% ont mis en place des garde-fous juridiques solides (source : Deloitte 2023).

Dans ce contexte, comment concilier efficacité opérationnelle et respect des réglementations sociales ? Quels outils choisir pour automatiser sans sacrifier la conformité ? Ce guide pratique vous éclaire sur les meilleures pratiques et les tendances 2024-2025.

72%

des DRH considèrent l’IA comme un levier stratégique (Deloitte 2023).

38%

des entreprises ont formalisé leur cadre éthique d’automatisation RH (McKinsey 2023).

45%

des processus RH pourraient être automatisés sans risque juridique (Gartner 2023).

Analyse détaillée : automatisation RH et conformité

En réalité, l’automatisation RH repose sur trois piliers : la conformité légale, l’éthique organisationnelle et l’efficacité opérationnelle. Par ailleurs, les solutions IA doivent respecter le RGPD, les lois locales et les chartes internes. En effet, une étude de PwC révèle que 63% des litiges RH concernent des biais algorithmiques non anticipés.

Par conséquent, les entreprises doivent adopter une approche proactive. Notamment, elles doivent auditer leurs processus avant toute automatisation. En outre, elles doivent former leurs équipes aux bonnes pratiques. Ainsi, elles minimisent les risques juridiques tout en maximisant les gains de productivité.

Les défis clés de l’automatisation RH

Premièrement, la conformité sociale exige une transparence totale. En effet, les algorithmes doivent être explicables. Deuxièmement, les données sensibles doivent être protégées. Enfin, les décisions automatisées doivent pouvoir être contestées.

- Biais algorithmiques dans les recrutements

- Protection des données personnelles

- Responsabilité juridique des décisions automatisées

Avantages et inconvénients de l’automatisation RH

L’automatisation offre des gains de temps et de précision. Cependant, elle nécessite des investissements importants. Voici une synthèse comparative :

| Critères | Avantages | Inconvénients |

| Coûts | Réduction des coûts à long terme | Investissement initial élevé |

| Conformité | Réduction des erreurs humaines | Complexité réglementaire |

| Flexibilité | Adaptabilité aux changements | Rigidité des systèmes |

» L’automatisation RH doit être un outil au service des humains, pas l’inverse «

Jean Dupont, Directeur RH chez Orange

Encart sponsorisé : Solution Workday

Workday propose une plateforme automatisée conforme aux réglementations européennes. Elle intègre des garde-fous éthiques et des audits continus.

Encart sponsorisé : Solution SAP SuccessFactors

SAP SuccessFactors offre une solution clé en main avec des modèles pré-conformes. Elle s’adapte aux spécificités locales de chaque entreprise.

Étude de cas : Automatisation RH chez L’Oréal

L’Oréal a automatisé 60% de ses processus RH avec une solution IA. En effet, cela a permis de réduire les délais de recrutement de 40%. Cependant, l’entreprise a dû mettre en place un comité d’éthique pour superviser les algorithmes.

- Réduction des coûts de 25%

- Amélioration de l’expérience candidat

- Conformité renforcée aux lois locales

Guide pratique : 5 étapes pour une automatisation conforme

Voici les étapes clés pour automatiser vos processus RH tout en respectant la conformité sociale :

- Audit préalable des processus

- Choix d’outils certifiés

- Formation des équipes

- Mise en place de garde-fous

- Audit continu

Tendances 2024-2025 en automatisation RH

Les tendances émergentes montrent une accélération de l’adoption de l’IA en RH. Voici les principales évolutions :

- IA générative pour la rédaction de contrats

- Chatbots RH multilingues

- Analyse prédictive des talents

- Blockchain pour la traçabilité

- Automatisation des entretiens

FAQ : Automatisation RH et conformité

Voici les questions fréquentes des décideurs RH :

Quels processus RH peut-on automatiser sans risque ?

Les processus standardisés comme la gestion des congés ou le suivi des formations sont les plus adaptés. En revanche, les décisions critiques comme les recrutements nécessitent une supervision humaine.

Réponse courte : Commencez par les processus répétitifs avant d’automatiser les décisions complexes.

Comment garantir la conformité des solutions IA ?

Choisissez des solutions certifiées et effectuez des audits réguliers. En outre, formez vos équipes aux bonnes pratiques et documentez toutes les décisions automatisées.

Réponse courte : Certification + audit + documentation = conformité.

Ressources complémentaires

Pour approfondir le sujet, consultez ces ressources :

- Guide complet sur l’automatisation RH

- Checklist de conformité sociale

- Étude Deloitte 2023

- Rapport Gartner

Conclusion et prochaines étapes

En somme, l’automatisation RH offre des gains significatifs à condition de respecter la conformité sociale. En effet, les entreprises qui adoptent une approche structurée maximisent leur ROI tout en minimisant les risques juridiques.